אלגוריתמים של למידה חישובית הולכים ונהיים במהירות חלק משגרת היומיום. סביר להניח שלמידה חישובית, שהיא ענף בתחום הבינה המלאכותית, נמצאת בשימוש רב משאנשים נוטים לחשוב. לרוב, אנחנו כלל לא מודעים לכך שאלגוריתם מעורב בעניין זה או אחר. כבר עכשיו אפשר למצוא אותם בכל מקום: בעוזרים וירטואליים בטלפון החכם, בתכנון מסלול נסיעה, בתוצאות חיפוש באינטרנט ‒ והרשימה הולכת ומתארכת. במצב שבו אלגוריתמים רבים ומורכבים הקשורים אלה באלה מיושמים לצרכים תעשייתיים, תעבורתיים ורפואיים, קיים צורך הולך וגדל להבין מדוע אלגוריתם ML הגיע לתוצאה מסוימת בעקבות הסקת מסקנות. המונח Explainable AI (בינה מלאכותית מוסברת – xAI) משמש יותר ויותר לתיאור תוצאה של אלגוריתם והגורמים ברקע שעליהם אותה תוצאה התבססה.

במאמר זה נציג את המושג xAI ונסביר מדוע הוא מהווה שיקול מהותי בכל יישום חדש של למידה חישובית.

AI ולמידה חישובית בחיי היומיום

קשה לומר בדיוק מתי הפכה הלמידה החישובית (ML) לחלק מחיי היומיום שלנו. לא הייתה שום השקה גדולה, לפעמים אפילו לא היה שום אזכור, אבל לאט ובטוח ML הפך לחלק מהותי מהאינטראקציה היומית שלנו עם טכנולוגיה. אצל רבים מאיתנו, המפגש הראשון שלנו התקיים דרך עוזרים וירטואליים בטלפון החכם, כמו Voice של Google או Siri של Apple. גם בתחום התעבורה, הפך ML במהרה לפונקציה דומיננטית במערכות סיוע מתקדמות לנהגים (ADAS), כגון בקרת שיוט אדפטיבית (ACC), בקרת סטייה מנתיב (ALA) וזיהוי תמרורים. מעבר לכך, יש יישומים רבים אחרים שייתכן כי איננו מודעים לכך ש-ML משמש בהם. חברות פיננסיות וחברות ביטוח משתמשות ב-ML עבור פונקציות שונות של עיבוד מסמכים, ואילו מערכות רפואיות ומערכות לאבחון בריאותי מנצלות את היכולת של ML לזהות דפוסים בסריקות MRI ובתוצאות בדיקות של מטופלים.

במהרה הפך ML לחלק מחיי היומיום שלנו, ומהר מאוד נהיינו תלויים בו בגלל יכולתו לקבל החלטות מהירות.

הבנת תהליך קבלת ההחלטות של אלגוריתם

האמון והתלות שלנו בהחלטות שמתקבלות על-ידי יישומים המבוססים על למידה חישובית הובילו לאחרונה להבעת חששות מצד קבוצות המתמקדות בצרכנים ובאתיקה מקצועית.

כדי להבין כיצד מערכות ML קובעות סבירות של תוצאה, תחילה נסקור בקצרה את אופן הפעולה שלהן.

למידה חישובית משתמשת באלגוריתם כדי לחקות את תהליך קבלת ההחלטות של המוח האנושי. כדי ליצור אלגוריתם, נוירונים במוח שלנו משתכפלים לפי מודל המבוסס על חישובים מתמטיים של הרשת העצבית. בדומה למוח שלנו, האלגוריתם של הרשת העצבית המלאכותית (ANN) מסוגל להסיק תוצאה על בסיס הידע הנרכש במידה מסוימת של סבירות. כפי שכולנו עושים מהרגע שנולדנו, רשת ה-ANN מפתחת הבנה דרך למידה. אימון ANN הוא חלק יסודי בכל מודל של למידה חישובית. בנוסף, סוגים שונים של מודלים של רשת עצבית מתאימים טובים יותר למשימות ספציפיות; לדוגמה, רשת קונבולוציה (CNN) הכי תתאים לזיהוי תמונות, ואילו רשת עצבית חוזרת (RNN) תתאים לעיבוד דיבור. המודל רוכש מידע באמצעות עיבוד כמויות עצומות של נתוני אימון. עבור CNN, נדרשות עשרות אלפי תמונות של סוגים שונים של חיות בליווי שמותיהן, לצורך זיהוי חיות. נדרשות תמונות רבות לכל זן ומין, ותמונות שצולמו מזוויות שונות ובתנאים שונים של תאורת סביבה. לאחר שבוצע אימון של המודל, מתחיל תהליך הבדיקה, בעזרת נתוני תמונות לבדיקה שהמודל טרם עיבד. המודל יוכל להסיק תוצאה על בסיס הסבירות של כל תמונת נתונים לבדיקה. סבירות ההסקה גדלה ככל שיש יותר נתוני אימון וככל שקיים מיטוב של הרשת העצבית.

ברגע שסבירות ההסקה הדרושה למשימה הגיעה לרמה גבוהה מספיק, מפתחי היישומים יוכלו לפרוס את מודל הלמידה החישובית.

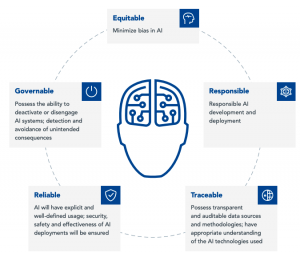

איור 1 :הגישה ההוליסטית של NXP לתהליך AI אתי ואמין (מקור: NXP)

יישום תעשייתי פשוט מבוסס-קצה של למידה חישובית הוא ניטור מצב של מנוע בעזרת ניטור חתימת הרטט שלו. ניתן לתעד סדרה מפורטת של חתימות רטט על ידי הוספת חיישן רטט (piezo, MEMS או מיקרופון דיגיטלי) למנוע תעשייתי. הוצאת מנועים מהשטח עקב תקלות מכניות (מיסבים שחוקים, בעיות נהיגה וכו’) מוסיפה לעומק של נתוני האימון. המודל שייווצר בעקבות זאת יוכל לנטר מנוע באופן רציף ולספק תובנה מתמשכת לגבי תקינות המנוע. רשתות עצביות כאלה, הפועלות בבקר זעיר בהספק נמוך, נקראות TinyML.

מה זה Explainable AI?

כפי שצוין בקטע הקודם, התוצאות של יישומים מסוימים מבוססי-ML עוררו חשש שמא הן מוטות באופן כזה או אחר. ישנם כמה היבטים בנוגע לדיון על כך ש-ML ואלגוריתמים של AI מציגים הטיה, והתפיסה המקובלת והרווחת היא שכל התוצאות של ML חייבות להיות שקופות יותר, הוגנות, אתיות ומוסריות. מרבית הרשתות העצביות פועלות כפונקציית “קופסה שחורה”; נתונים נכנסים, ויוצאת תוצאה ‒ המודל לא מספק כל תובנה לגבי האופן שבו התוצאה נקבעה. באופן כללי, ישנו צורך הולך וגדל בקבלת הסבר בנוגע לבסיס שעליו התקבלה התוצאה של האלגוריתם. התוצאות חייבות להיות חוקיות ואתיות, כלומר ניתנות להסבר ‒ Explainable AI (xAI).

במאמר קצר זה, נוכל רק לגעת על קצה המזלג בתפיסות שעומדות מאחורי xAI, אולם הקוראים ימצאו מידע רב בסקירות הטכניות של יצרנית המוליכים למחצה NXP ושל PWC, שהיא חברת ייעוץ להתנהלות עסקית.

כדי להמחיש את הדרישות של xAI, נתבונן בשני תרחישי יישום אפשריים.

תעשיית הרכב ‒ בקרה של כלי רכב אוטונומיים: נניח שאתם נוסעים במונית שנוהג בה אדם. אם הנהג נוסע במהירות נמוכה, אתם עשויים לשאול “למה אתה נוסע לאט כל-כך?” בתשובה, הנהג עשוי להסביר לכם שתנאי הקרה גרמו להיווצרות קרח על הכבישים, ולכן הוא נזהר במיוחד כדי למנוע החלקה של המונית ואיבוד השליטה עליה. לעומת זאת, במונית אוטונומית, אין אפשרות לבקש מהנהג להסביר את החלטותיו. סביר להניח שההחלטה על נסיעה במהירות נמוכה נובעת ממספר מערכות של למידה חישובית התלויות אלה באלה (סביבה, אחיזת כביש וכו’), שכולן פועלות יחד כדי להסיק כי מהירות נמוכה היא הבחירה השקולה. חלק אחר במערכות הנהיגה העצמית ברכב אמור למסור לנוסע את הסיבות להחלטות בצורת קול ותמונות, כדי לספק לו מידע ולהרגיע אותו במהלך הנסיעה.

בריאות ‒ אבחון מצב רפואי של מטופל: חשבו על כך שמערכת אוטומטית תאיץ את הזיהוי של בעיות מסוגים שונים בעור. צילום אנומליה בעור של מטופל מוזן ליישום, והפלט נשלח אל רופא עור לצורך הצעת טיפול. קיימות הפרעות מסוגים שונים בעור האנושי. חלקן זמניות, אחרות קיימות באופן קבוע, חלק מהן אף כואבות. חומרת מצבי העור נעה מקלה יחסית למסכנת חיים. בגלל המגוון הרחב של הפרעות אפשריות, ייתכן שרופא העור יהיה סבור כי יש צורך בהמשך אבחון הבעיה לפני שימליץ על צורת טיפול. אם יישום ה-AI יוכל להציג את הסבירות של האבחנה ושל תוצאות אחרות שהוסקו בדרגה גבוהה, המומחה יוכל לקבל החלטה מושכלת יותר.

שני התרחישים הפשוטים שהבאנו ממחישים מדוע יש לשקול בכובד ראש xAI. קיימות דילמות אתיות וחברתיות רבות נוספות במסגרת השימוש ב-AI וב-ML, שאף אותן יצטרכו לשקול ארגוני שירותים פיננסיים וממשל.

במסגרת תכנון מערכות של למידה חישובית, אלה כמה מהנקודות שמפתחי Embedded יצטרכו לבחון.

- האם נתוני האימון מהווים דוגמה רחבה ומגוונת מספיק של הפריט שלגביו נדרשות מסקנות?

- האם הוכח שנתוני הבדיקה מכילים ייצוג שווה של כל קבוצות הסיווג שזוהו בכמויות מספיקות?

- האם התוצאה שהוסקה בעזרת האלגוריתם מחייבת הסבר?

- האם הרשת העצבית יכולה לספק תשובה על בסיס מידת הסבירות של התוצאות שהיא לא כללה?

- האם יש אילוצים משפטיים או רגולטוריים שמכסים את נתוני העיבוד של יישומי ה-ML?

- האם יישום ה-ML בטוח מפני מתנגדים המעמידים אותו בסכנה?

- האם ניתן לתת אמון ביישום ה-ML?

פיתוח יישומי למידה חישובית

מפתחי Embedded רבים עובדים כעת בפרויקטים שכוללים פונקציה של למידה חישובית, בדומה לדוגמה של TinyML שהובאה בקטע המבוא. עם זאת, תהליך ה-ML אינו מוגבל לפלטפורמות מבוססות-קצה; התפיסות ניתנות להרחבה במידה רבה מאוד לפריסות תעשייתיות גדולות. דוגמאות לפריסות של ML בתעשיות שונות כוללות ראייה ממוחשבת, ניטור מצבים, בטיחות ואבטחה.

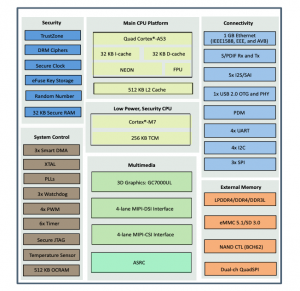

ספקים מובילים בענף המוליכים למחצה מציעים כעת בקרים זעירים ומעבדים זעירים הממוטבים ליישומי למידה חישובית. דוגמה אחת היא מעבדי היישומים NXP iMX-8M Nano-Ultralite. כחלק מסדרת NXP iMX-8M Plus, ה-Nano-Ultralite (NanoUL) מצויד במעבד ראשי בעל ארבע ליבות מסוג Arm® Cortex®-A53, הפועל במהירויות של עד 1.5GHz ובמעבד ליבה Cortex-M7 רב-תכליתי הפועל במהירויות של עד 750MHz, עבור משימות בזמן אמת ובהספק נמוך.

איור 2 מדגיש את הבלוקים הפונקציונליים העיקריים של iMX-8M NanoUL, הכולל סדרה מקיפה של בלוקים לגבי קישוריות, ממשקים היקפיים, פונקציות בטיחות, שעונים, טיימרים, קוצבי-זמן מפקחים (Watchdogs) ו-PWM. גודלו של מעבד היישומים הקומפקטי NanoUL הוא 11 מ”מ x 11 מ”מ.

איור 2 ‒ תרשים הבלוקים הפונקציונליים של NXP iMX-8 Plus NanoUL (מקור: NXP)

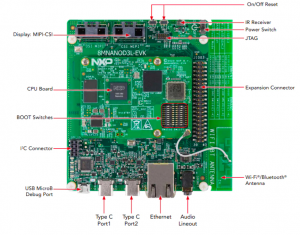

על מנת לסייע למפתחים לתכנן יישומים של iMX-8 Plus NanoUL, חברת NXP מציעה את i.MX 8M Nano UltraLite Evaluation Kit ‒ המתוארת באיור 3. הערכה, הכוללת לוח אם ולוח מעבד NanoUL, מספקת פלטפורמה מקיפה ומלאה שעליה ניתן לפתח יישום של למידה חישובית.

איור 3 ‒ ערכת ההערכה NXP i.MX 8M NanoUL Evaluation Kit כשהרכיבים העיקריים מודגשים (מקור: NXP)

כבר קיים אקוסיסטם מבוסס של משאבים, מסגרות ופלטפורמות פיתוח ללמידה חישובית, לצורך תכנון אב-טיפוס של ML, בין שהוא מתבסס על MCU מבוסס-קצה בהספק נמוך או על MPU רב-עוצמה.

TensorFlow Lite הוא ואריאנט של TensorFlow ‒ ספריית קוד פתוח ל-ML ברמה ארגונית של Google ‒ המיועד במפורש עבור בקרים זעירים בהספק נמוך ומשאבים בכמות נמוכה. הוא יכול לפעול בליבות מסדרת Arm Cortex-M ולתפוס 18kB בלבד מנפח הזיכרון. TensorFlow Lite מספק את כל המשאבים עבור פריסת מודל במכשירים משובצי מחשב.

חברת Edge Impulse נוקטת גישה כוללנית יותר, עם פתרון קצה-לקצה המכסה הזנת נתוני אימון, בחירת המודל האופטימלי של רשת עצבית עבור היישום, בדיקות ופריסה סופית למכשיר קצה. Edge Impulse עובדת עם מסגרות ה-ML לקוד פתוח TensorFlow ו-Keras.

התפתחויות ב-Explainable AI

למידת אופן התכנון והפיתוח של יישומי ML משובצים מציעה הזדמנויות משמעותיות למהנדסי מערכות Embedded לפיתוח כישוריהם. זמן החשיבה על המפרט וההפעלה של יישום הקצה הוא גם המועד המושלם לבחון כיצד העקרונות של Explainable AI יחולו על התכנון. Explainable AI משנה את האופן שבו אנחנו חושבים על למידה חישובית, ומפתח Embedded עשוי לתרום תרומה משמעותית על ידי הוספת הקשר, ביטחון ואמון נוספים ליישום.