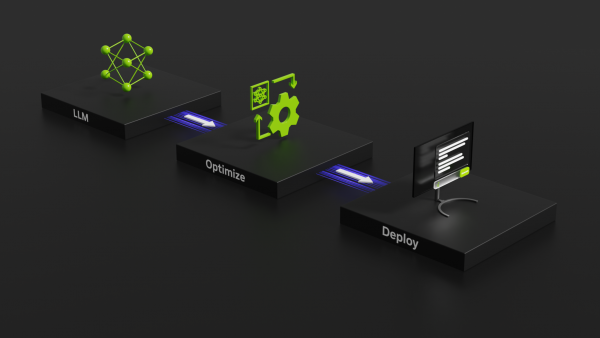

מודלי שפה גדולים (LLMs) הם אבני היסוד של כמה מיישומי ה-AI הבולטים ביותר בתקופה האחרונה. אבל גודלם ומאפייני היישום שלהם מהווים חסמים עבור ארגונים, שמתקשים לשלב אותם בפעילות השוטפת באופן יעיל וחסכוני.

על הרקע הזה פעלה אנבידיה בשיתוף פעולה עם שורה של חברות בולטות בתחום, בהן מטא, Grammarly, Deci, Cohere ואחרות, על מנת להאיץ ולייעל את תהליך ההסקה (Inference) של מודלי שפה גדולים (LLMs), וזאת באמצעות חבילת תוכנה חדשה בקוד פתוח בשם NVIDIA TensorRT-LLM, שתשוחרר בשבועות הקרובים.

חבילת התוכנה NVIDIA TensorRT-LLM תאפשר למפתחים להתנסות במודלי שפה חדשים, להגיע לאופטימיזציה ביישום שלהם ולהתאים אותם לצרכים הספציפיים של הארגון, גם ללא ידע נרחב בשפות כגון ++C או NVIDIA CUDA. כך למשל, בעוד עד עתה היה ה-NVIDIA H100 GPU מהיר פי ארבע ממעבדי A100 בביצועי Inference, השימוש ב-TensorRT-LLM, מביא לשיפור כפול של פי שמונה בהשוואה ל-A100. דוגמה נוספת היא שימוש במודל השפה הפופולרי LLAMA 2 של מטא, ומשמש ארגונים רבים לשילוב יכולות בינה מלאכותית יוצרת בפעילותם. הוספת TensorRT-LLM האיצה את שלב ההסקה בשימוש במודל פי 4.6 לעומת הרצה על מעבדי NVIDIA A100 – כל זאת באמצעות אופטימיזציה ברמת התוכנה בלבד.

קרדיט: NVIDIA