בינה מלאכותית (בראשי תיבות: AI) זקוקה לכמויות עתק של נתונים כדי לבצע תחזיות, והעיבוד של הנתונים האלה צורך אנרגיה רבה. imec פיתחה פתרונות להפחתה משמעותית של צריכת האנרגיה. פריצת הדרך הנוכחית הושגה באמצעות פיתוח שבב חדש שבו מתבצעים חישובי הבינה המלאכותית ישירות בזיכרון באמצעות טכנולוגיה אנלוגית.

תקציר:

- צריכת האנרגיה של חישובי בינה מלאכותית גבוהה מאוד, ושליחת הנתונים ממכשירי הקצה לחוות הנתונים ובחזרה מגדילה אותה עוד יותר.

- אנחנו יכולים להפחית את צריכת האנרגיה באופן משמעותי אם נבצעחישובי זיהוי חוקיות במקום הכי הגיוני: מכשירי קצה כמו חיישן אלחוטי, במכשיר נייד או במכונית.

- imec פיתחה שבב חדש וחסכוני מאוד באנרגיה בדיוק למטרה הזאת.

כדור הארץ מתחמם. המאבק לצמצום ההתחממות העולמית מחייב הפחתת פליטות גזי חממה. זאת אחת המטרות של תכנית בשם “לאירופה הוגנת, לא מזהמת ודיגיטלית (באנגלית: Towards a fair, climate-neutral and digital Europe) שעליה הכריזה הנציבות האירופית בשנת 2020. בנוסף לשינויי האקלים, העולם מתמודד היום גם עם המעבר לדיגיטל וגם אליו מתייחסת התוכנית של הנציבות האירופית, ובפרט לבינה מלאכותית. על פי הנציבות האירופית “טכנולוגיות כגון בינה מלאכותית יהיו אחד מגורמי המפתח בהשגת היעדים של יוזמת Green Deal” כך שיש קשר הדוק בין הדברים. הרעיון הוא פשוט: שימוש בבינה מלאכותית ככלי במאבק בהתחממות העולמית.

העלות הסביבתית של בינה מלאכותית

לבינה מלאכותית יש פוטנציאל גדול, כמו לדוגמה חיזוי מדויק יותר של שינויים באקלים לצורך איתור הפסדי אנרגיה או ענפי תעשיה שבהם צריך להקטין את טביעת הרגל הפחמנית. עם זאת, לשימוש בטכנולוגיה יש מחיר סביבתי משלו. יישומי בינה מלאכותית מבוססים על עיבוד של כמויות גדולות מאוד של מידע (נתוני עתק), וכבר היום היא אחראית על צריכת חלק לא מבוטל מהחשמל שמיוצר בכל רחבי העולם. ואם לא די בכך, הרי שכמות החישובים רק הולכת וגדלה. למרות שהחישובים האלה מתבצעים בדרך כלל בחוות שרתים ענקיות שהפכו בשנים האחרונות ליותר חסכוניות באנרגיה ואף התחילו להשתמש באנרגיה מתחדשת כדי לספק חלק מצורכיהן, השפעתן על הסביבה עדיין גדולה.

לדוגמה: בשנה שעברה חישבו חוקרים מאוניברסיטת מסצ’וסטס את שיעור פליטת גזי החממה מהרצת מודלים לאימון עיבוד שפה טבעי (המשמשים לשיפור תרגום מכונה). כדי לעשות זאת הם הריצו את האלגוריתמים לזמן קצר על מעבד גרפי (GPU) אחד, ומשם השליכו מהפרט אל הכלל. הם חישבו מהי צריכת האנרגיה של המודלים האלה לפי משך הזמן הדרוש לביצוע החישובים, ואז המירו את אותה לפליטת פחמן דו־חמצני בהתבסס על פליטת הפחמן הדו־חמצני הממוצעת של ספקי מחשוב ענן. החוקרים מצאו כי האלגוריתמים שצורכים את כמות האנרגיה הגדולה ביותר אחראים לפליטת עד ל־284 טונות של פחמן דו־חמצני. נתון זה שווה ערך לכמות הפחמן הדו־חמצני שפולטות חמש מכוניות לכל אורך חייהן, כולל ייצורן במפעל.

העלאת המודעות למחיר הסביבתי של בינה מלאכותית הובילה לכך שחוקרי בינה מלאכותית התחילו לעקוב אחרי צריכת האנרגיה של האלגוריתמים שהם מפתחים. החוקרים משתמשים במחשבון פליטת פחמן דו־חמצני ליישומי לימוד מכונה שבו הם מזינים את משך זמן החישוב, את חומרת המחשב ואת שירות הענן שבהם השתמשו כדי לקבל את פליטת הפחמן הדו־חמצני המשוערת של האלגוריתמים שלהם, והחלו לפרסם אותה במאמרים שלהם.

חומרה ירוקה לבינה מלאכותית

אפשר להקטין את טביעת הרגל הפחמנית בשתי דרכים: תוכנה וחומרה. אפשר לנסות לפתח אלגוריתמים יעילים יותר שיקטינו את מספר החישובים. דוגמה טובה לכך היא שיטה הנקראת צמצום הרשת (Network pruning) שבה מוסרים מהרשת כל החלקים שאינם נחוצים להשגת התוצאה הסופית. בשיטה הזאת מתקבלת רשת נוירונים קטנה יותר, מהירה יותר וחסכונית יותר באנרגיה, מבלי לפגוע ביכולות שלה.

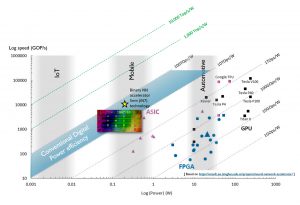

הגישה השנייה היא פיתוח של רכיבי חומרה חסכוניים יותר באנרגיה. כיום נעשים חישובי הבינה המלאכותית בעיקר על מעבדים גרפיים (GPU). המעבדים האלה לא תוכננו למטרה הזאת, אבל הם עושים אותה היטב. אחד הגורמים שהובילו לצמיחה המהירה של רשתות נוירונים הוא הזמינות הרחבה של מעבדים גרפיים. בשנים האחרונות פותחו גם מעבדים ייעודיים לחישובי בינה מלאכותית, כמו מעבדי Tensor של גוגל (בראשי תיבות באנגלית: TPU). המעבדים האלה יכולים לבצע יותר חישובים בשנייה לעומת מעבדים גרפיים, אבל צורכים את אותה כמות אנרגיה. מערכות אחרות משתמשות במעבדי FPGA שצורכים פחות אנרגיה, אבל גם איטיים יותר. כשמשווים את הביצועים כפונקציה של צריכת האנרגיה, מעבדי ASIC, המתחרים במעבדי FPGA, מציגים את היחס הטוב ביותר. תרשים 1 מציג השוואה של הקשר בין מהירות החישוב וצריכת האנרגיה של מעבדים שונים. הקשר שבין מהירות החישוב לצריכת האנרגיה מבוטא ביחידות של TOPS/W (טרה־פעולות לשנייה לכל ואט; או כמה טריליון חישובים אפשר לבצע לכל יחידת אנרגיה). אולם, כדי שנצליח להגדיל את היעילות האנרגטית מ־1 TOPS/W ל־10,000 TOPS/W, אנחנו צריכים טכנולוגיה חדשה לגמרי.

תמונה 1:

In order to process AI calculations directly on IoT sensors, mobile

devices or in cars, the energy efficiency of the hardware (visualised

using the grey diagonals) must be drastically increased.

מהענן למכשירי קצה

כיום רוב החישובים מתבצעים בחוות שרתים גדולות אבל אפשר לבצע את חישובי הבינה המלאכותית גם במקום אחר. “אפשר להפחית מאוד את צריכת האנרגיה על ידי ביצוע החישובים באופן מקומי”, אומר דידריק ורקסט (Diederik Verkest), מנהל תכנית למידת המכונה ב־imec. “צריכת האנרגיה של חוות השרתים בעולם היא עצומה, אבל זה רק חלק מהעניין. צריכת האנרגיה הדרושה להעברת המידע בין מכשירי הקצה לחוות השרתים גדולה לא פחות. אם נוכל לבצע את החישובים במכשירי הקצה עצמם, נוכל לחסוך את האנרגיה הדרושה לשליחתם אל חוות השרתים”.

פתרון כזה יתכתב נהדר עם מגמת המעבר מהענן למכשירי הקצה, שכבר נמצאת בעיצומה. יותר ויותר מידע נאסף היום על ידי מכשירים שרק הולכים ונעשים קטנים יותר. אם אנחנו רוצים לעבד את המידע הזה ישירות במכשירי הקצה, הצעד הראשון הוא הפחתת צריכת האנרגיה הדרושה לחישובים האלה. עד כמה להפחית? “התשובה לשאלה הזאת תלויה בגודל המכשיר שמבצע את החישובים”, מסביר ורקסט. מכשירי קצה מגיעים בגדלים ובצורות שונות. מכשיר קצה יכול להיות חיישן אלחוטי קטן או מכשיר טלפון נייד, אבל גם מכונית ללא נהג. “במכונית ללא נהג קבלת החלטות מהירה היא חיונית ואין זמן לשלוח את הנתונים לחוות שרתים, להמתין לסיום החישוב ואז לקבלת התוצאה. זאת הסיבה שבמכונית מותקן מספר גדול של מעבדים גרפיים שמפענחים את התמונות באופן מקומי”, מסביר ורקסט.

“במקרה של פענוח אוטומטי של תמונות אנחנו מדברים על סדר גודל של 20 מיליון פעולות כדי לזהות פרט מידע אחד. בחוות שרתים החישובים האלה מתבצעים תוך שבריר שנייה על גבי מעבד גרפי שצורך 200 ואט לערך. אם אפשר להסתפק בפענוח תמונה תוך שנייה אחת, הרי שמספיק מעבד גרפי שצורך 20 ואט. זה עדיין בגבול המעשי במכונית, אבל עבור מכשירים קטנים יותר מדובר בצריכת אנרגיה גבוהה מדי. אם ניקח לדוגמה טלפון נייד עם סוללה בקיבולת 4,000 מיליאמפר־שעה, הרי שהיא יכול לספק לנו 14.8 ואט־שעה. אם נפעיל בעזרתה מעבד גרפי שצורך 20 ואט, הסוללה תתרוקן תוך פחות משלושת רבעי שעה. כשמדובר בחיישנים אלחוטיים במכשירי IoT (האינטרנט של הדברים), על הסוללה להחזיק זמן רב הרבה יותר ולכן השימוש במעבדים האלה אינו מעשי. אין לנו כרגע פתרון לשוק האינטרנט של הדברים”, מודה ורקסט. “זאת הסיבה שאנחנו עובדים על פיתוח פתרונות חדשים.

ארכיטקטורת המחשוב המסורתית כבר לא מספיקה

כדי שמכשירים אלחוטיים יוכלו לקבל החלטות במהירות, אנחנו זקוקים לארכיטקטורות מחשוב חדשות. ובפרט, שבבי חישוב עם צריכת אנרגיה נמוכה. כדי שהאלגוריתם יוכל לתת תחזית, תחילה צריך לאמן אותו. את החישובים של שלב הלמידה אפשר לבצע מבעוד מועד בחוות השרתים. בסיום שלב הלמידה, המכשיר החכם יוכל לעבד מידע חדש בכוחות עצמו ולתת את התחזית הנכונה. סוג החישובים הזה נקרא הסקה, והוא זה שיבוצע במכשיר הקצה עצמו.

כך לדוגמה: נניח שלימדנו מערכת בינה מלאכותית להבדיל בין חתול וכלב. פירושו של דבר שהזנו לרשת הנוירונים מספר גדול מאוד של תמונות בליווי משוב רציף, עד שהיא ביצעה את ההתאמות הנדרשות והצליחה לתת את התשובה הנכונה. אם נציג לה עכשיו תמונה חדשה של בעל חיים, ייתן האלגוריתם תשובה נכונה (זה חתול או זה כלב) ברמת דיוק של 95%. כדי להגיע לתשובה הנכונה השתמשה המערכת כמויות עצומות של נתונים. היא לא עיבדה רק את נתוני התמונה החדשה של החתול או הכלב, אלא גם השתמשה בכל המידע שלמדה בעבר. העברת המידע הזה צורכת המון אנרגיה.

מימיו הראשונים של עידן המחשב הדיגיטלי, המעבד היה רכיב נפרד מהזיכרון. המעבד מבצע פעולות על נתונים שמתקבלים מהזיכרון. אם הפעולות האלו מבוצעות על נתוני עתק, אחזור המידע מהזיכרון לוקח לפעמים זמן רב יותר מזה הדרוש לביצוע הפעולה. הבעיה הזאת בולטת במיוחד כשמדובר בחישובי בינה מלאכותית, בגלל שבחישובי שלב ההסקה מתבצעת הכפלה של וקטורים ומטריצות גדולים.

כמו כן, כל פעולה מבוצעת ברמת דיוק של מחשב דיגיטלי וצורכת הרבה אנרגיה. עם זאת, בשנים האחרונות מצאו חוקרים כי התוצאה (זיהוי חוקיות) כמעט שלא מושפעת מרמת הדיוק של כל פעולה בודדת. ההבנה הזאת יכולה להוביל לחסכון באנרגיה, כי פירושו של דבר שאפשר לבצע את החישובים קרוב ככל האפשר לזיכרון במחיר של רמת דיוק נמוכה יותר. זה העקרון שעליו מבוססת הגישה שהציעה קבוצת המחקר של ורקסט, המשנה לגמרי את ארכיטקטורת המחשוב המסורתית: החישובים מבוצעים ישירות בזיכרון באמצעות טכנולוגיה אנלוגית.

הגישה האנלוגית

במבט ראשון נדמה ששימוש במערכת אנלוגית בתוך מערכת דיגיטלית היא החלטה תמוהה בעולם שבו הכול עובר לדיגיטל. שיטות אנלוגיות משתמשות באותות רציפים והן פחות מדויקות משיטות דיגיטלית המשתמשות ברצף של אפסים ואחדות. אך כפי שהזכרנו קודם לכן, אין צורך לבצע כל חישוב ברמת דיוק גבוהה כדי להשיג תוצאה סופית מדויקת. ועוד יותר מזה, הגישה האנלוגית מאפשרת להשיג את אותה תוצאה מהר יותר והיא חסכונית יותר באנרגיה.

אכן כן! בעזרת עקרונות הנדסת חשמל אפשר לבצע את פעולות הכפלת הווקטורים והמטריצות בפעם אחת במקום זאת אחר זאת. אם המתח הוא ערכי הקלט וההתנגדות היא משתני הלמידה, אז הזרם הוא פעולת ההכפלה (חוק אוהם). אפשר לחבר בין כל פעולות ההכפלה (חוק הזרמים) כך שערך הזרם נותן את תוצאת הכפלת המטריצה בווקטור. בדרך זאת אפשר לבצע את החישובים בפעם אחת מבלי לאחזר את המשתנים שוב ושוב.

כדי להדגים שהגישה הזאת עובדת היטב גם באופן מעשי, שולבה הארכיטקטורה החדשה בתוך שבב. השבב נקרא מאיץ הסקה אנלוגי (Analogue Inference Accelerator, בראשי תיבות: AnIA) וביצועיו עומדים על 2,900 TOPS/W או 2,900 טריליון פעולות לג’ול. “זאת בסך הכול הטמעה די בסיסית שבעזרתה אנחנו מבקשים להדגים כי אפשר לבצע חישובים אנלוגיים בזיכרון”, אומר ורקסט. “אנחנו יכולים להשתמש בגישה הזאת ליצירת שבבים קטנים, וכבר עכשיו השבב הזה חסכוני באנרגיה פי 10 עד 100 לעומת שבבים דיגיטליים”.

בסופו של דבר אנחנו שואפים ליצור שבב שיציג ביצועים של 10,000 TOPS/W (10,000 טריליון פעולות לג’ול). הדרך לעשות זאת מתוארת במאמר שפורסם לאחרונה והציע תכנית לפיתוח השבבים הקטנים והמאוד יעילים אנרגטית האלה. השבבים האלה יאפשרו לחיישנים אלחוטיים לזהות חוקיות בכוחות עצמם על סמך הנתונים שאספו בעצמם. כבר לא יהיה צורך בשליחת נתונים הלוך ושוב בין מכשיר הקצה לחוות שרתים.

תמונה 2:

The Analog Inference Accelerator (AnIA) is an energy-efficient chip that

enables smart pattern recognition at the edge.

Bio Diederik Verkest

Diederik Verkest holds a Ph.D. in Applied Sciences from the KU Leuven (Belgium). After working in the VLSI design methodology group of imec (Leuven, Belgium) in the domain of system-on-chip design, he joined imec’s process technology unit as director of imec’s INSITE program focusing on co-optimization of design and process technology for sub-7nm nodes. Since 2018 he is in charge of imec’s ML program aiming at improving energy efficiency of ML hardware through innovation in circuits and devices.